«Heizt der Nachbar die Wohnung über 19 Grad auf? Bitte informieren Sie uns!» Diese angebliche Aufforderung des Bundes zirkulierte im September im Internet. Eine Fälschung. Im Gegensatz zu diesem harmlosen Scherz brachten die Anschuldigungen Donald Trumps, die Präsidentschaftswahl sei gestohlen, die USA 2021 an den Rand eines Bürgerkriegs.

Der Bund unterstützt die Forschung

Der Bundesrat möchte gefährliche Desinformations-Kampagnen frühzeitig erkennen. Deshalb forscht der Cyber-Defence Campus der Armasuisse, dem Bundesamt für Rüstung, daran, Fake News automatisiert aufzuspüren.

Aufgrund der riesigen zu prüfenden Datenflut setzen die Forschenden auf Methoden der künstlichen Intelligenz, konkret auf Machine Learning (ML). Dabei entdecken Algorithmen selbständig Muster in Daten. Ein gut trainiertes ML-Modell kann einen Tweet schnell klassifizieren: Fake News oder nicht?

Jagd auf Social Bots und Memes

Gérôme Bovet leitet bei Armasuisse die Gruppe für Datenwissenschaften, welche die KI entwickelt. Die laufenden Forschungsprojekte verfolgen einen doppelten Ansatz: «Wir versuchen zwei Dinge zu erkennen: Social Bots und Memes mit Desinformation», erklärt Bovet.

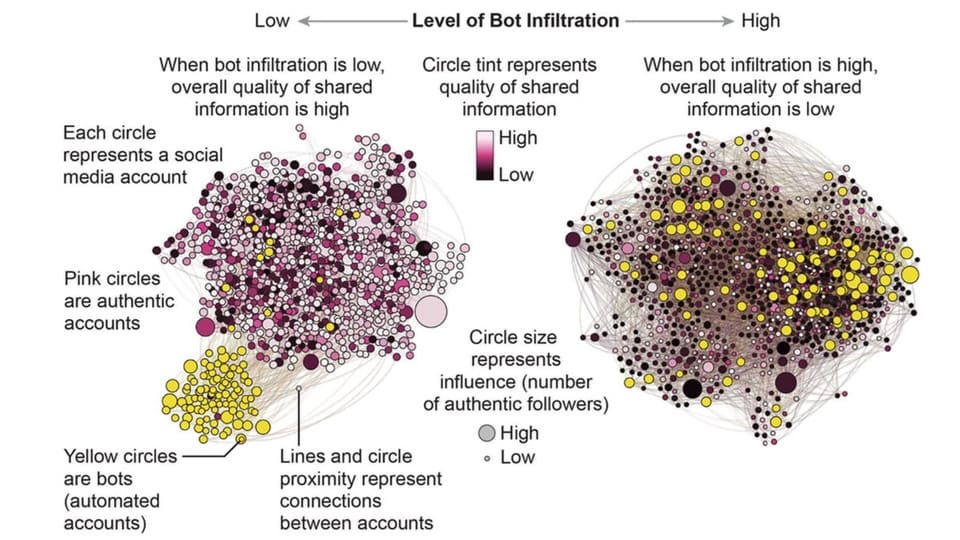

Social Bots sind automatisierte Social-Media-Konten – Konten also, hinter denen keine Menschen, sondern ein Computerprogramm sitzt. Memes wiederum sind Posts, die meist aus Bildern mit darübergelegten, witzigen Texten bestehen. Wenn beide zusammen kommen, wird es besonders brisant: Werden Fake News als Memes verpackt und von Bots im grossen Stil verbreitet, besteht die Gefahr, dass die Lügen besonders viele Nutzende erreichen.

Um das zu verhindern, werden die ML-Modelle mit Informationen über Meme-Texte, Bildeigenschaften und Statistiken der Absender-Konten gefüttert. Damit sollen die Lügner erkannt werden – in der Theorie.

War das sarkastisch gemeint?

In der Praxis kommt das Problem der Doppeldeutigkeit dazu. Für die Erkennung von Hassmeldungen ist Machine Learning bereits gut erforscht. Hier werden über 90 Prozent der Texte und 67 Prozent der Memes korrekt klassifiziert. Wie gut diese Methode indes bei Fake News funktioniert, lässt sich gemäss Bovet noch schwierig abschätzen. Hass lässt sich gut anhand von Fluchwörtern erkennen. Aber eine gehässige Nachricht muss nicht zwangsläufig falsch sein.

Eine Knacknuss seien sarkastische Memes, deren Bedeutung sich erst aus der Kombination von Text und Bild erschliesst.

Doch über all dem schwebt ein noch grundsätzlicheres Problem: So benötige das Training der ML-Modelle grosse Datensätze, in denen Social Bots und Memes bereits korrekt klassifiziert sind. Solche Daten seien schwierig zu erhalten: «Die Social-Media-Plattformen arbeiten kaum mit uns zusammen. Die Daten sind ihr Gold, das sie nicht herausrücken.», so Datenspezialist Bovet.

Wahrheit ist die Basis einer Demokratie

Obwohl noch einige Hürden zu nehmen sind, ist absehbar: Künstliche Intelligenz wird eine wichtige Rolle im Kampf gegen Desinformation spielen. Soziale Netzwerke könnten dadurch ihre Nachrichtenfeeds bereinigen und so mehr Werbekunden anlocken. Für freiheitliche Nationalstaaten wie die Schweiz wiederum steht noch mehr auf dem Spiel: Ein gemeinsames Verständnis davon, was wahr ist, bildet schliesslich die Basis jeder demokratischen Gesellschaft.