Dass ein Besuch bei Facebook auf die Stimmung schlagen kann, ist bekannt. Nun wollte das Social-Media-Unternehmen offenbar selber untersuchen, wie genau sich positive und negative Einträge im so genannten Newsfeed auf die Nutzerinnen und Nutzer auswirken. Der Newsfeed ist der Strom an Einträgen von Freunden, die jeder Nutzer auf seinem Facebook-Account präsentiert bekommt.

In Zusammenarbeit mit zwei amerikanischen Universitäten hat Facebook ein Experiment durchgeführt und darin nicht nur vorhandene Daten analysiert, sondern den Newsfeed der Nutzer direkt manipuliert. Ohne deren Einwilligung.

Spiel nicht mit meinen Gefühlen

In diesem Experiment konnten die Autoren zeigen, dass Facebook die Gefühle der Nutzer manipulieren kann: Wurden mehr positive Einträge von Freunden im Newsfeed angezeigt, schrieben die Nutzer, die diese sahen, selber mehr positive Posts. Mehr negative Einträge führten zu negativeren eigenen Posts.

Für die Autoren zeigen die Ergebnisse, dass die «emotionale Ansteckung» zwischen Menschen auch ohne direkte Interaktion stattfindet und so auch bei positiven Gefühlen wirkt. Das Experiment wurde im Januar 2012 unter knapp 690'000 englischsprachigen Facebook-Nutzern durchgeführt. Veröffentlicht wurde die Studie Anfang Juni in einem wissenschaftlichen Magazin in den USA, nun geht eine Welle der Entrüstung über Facebook her.

Die Empörung der Nutzer ist gross, viele fühlen sich von Facebook missbraucht, wie die «New York Times» schreibt. Der Fall demonstriert, dass Facebook die Daten nicht nur für Werbung verwenden, sondern noch viel weiter gehen kann.

Facebook verteidigt sich

Der Hauptkritikpunkt liegt darin, dass Facebook seine Benutzer ohne ihr Einverständnis als Versuchspersonen brauchte. Facebook verteidigt das Experiment damit, dass man «vorsichtig» Forschung betreibe, auch dank eines strikten Aufsichtsverfahrens. Es sei für Facebook wichtig zu verstehen, wie die Nutzer auf verschiedene Inhalte reagierten.

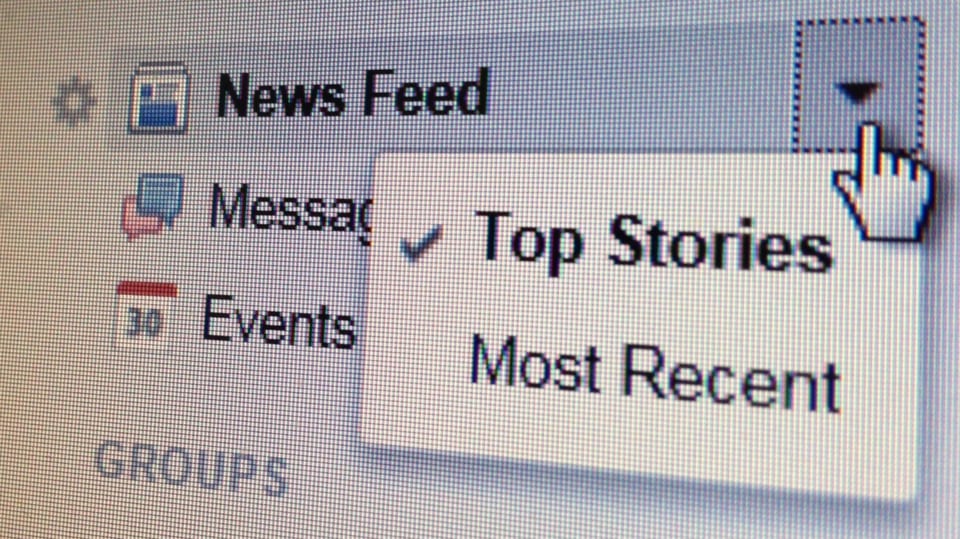

Tatsächlich unterliegt der Newsfeed auf Facebook einem geheimen Algorithmus. Dieser dient dazu, aus der Fülle von Facebook-Einträgen die für den Nutzer relevanten Inhalte herauszufiltern – zum Beispiel die Einträge derjenigen Freunde, mit denen am meisten interagiert wird. Für Facebook wäre der emotionale Gehalt von Einträgen also nur ein weiterer Baustein im Algorithmus. Sollte Facebook damit aber wirklich die Befindlichkeit seiner Nutzer beeinflussen können, wäre es eine Möglichkeit diese noch stärker an Facebook zu binden.

Erstautor der Studie und Facebook-Mitarbeiter Adam Kramer versucht auf seinem persönlichen Facebook-Profil, die Sache herunterzuspielen: Die Untersuchung habe lediglich eine Woche gedauert und nur einen sehr kleinen Teil der Nutzer betroffen. Ausserdem habe man keine Inhalte verändert oder weggelassen, sondern sie nur nicht immer im Feed angezeigt. Im Artikel zur Studie weisen die Autoren darauf hin, dass die Studie im Einklang mit den Datenschutzbestimmungen von Facebook stehe. Alle Nutzer hätten diesen ja zugestimmt. In akademischen Kreisen ist umstritten, ob dieses Vorgehen ethischen Kriterien genügt.

Machtmissbrauch verkannt

Damit verkennt Facebook die Symbolkraft dieses Vorfalls. Denn der Fall wirft ein Schlaglicht auf den Umgang von Unternehmen mit persönlichen Daten. Das führt nicht nur die Macht der Konzerne vor Augen, die Nutzerdaten sammeln, sondern zeigt im Falle von Facebook ihre Skrupellosigkeit, diese auch zu nutzen.