- Immer häufiger werden in bewaffneten Konflikten Kriegsroboter eingesetzt – viele Forscher warnen vor der Gefahr, die von dieser maschinellen Tötung ausgeht.

- Der amerikanische Roboterforscher Ron Arkin widerspricht: Automatische Waffensysteme könnten Leben retten, weil man sie im Gegensatz zu Soldaten darauf programmieren könnte, keine Zivilisten angreifen.

- Voraussetzung für den Einsatz von Kriegsrobotern ist laut Ron Arkin, dass ihnen ein «ethischer Chef», eine Art künstliches Gewissen, eingepflanzt wird.

Mehr Roboter im Krieg

Immer mehr Armeen setzen auf Roboter. Feindliche Stellungen werden mit unbemannten Drohnen angegriffen, manche Grenzen bereits mit bewaffneten Robotern gesichert.

Noch geben Menschen den letzten, tödlichen Schiessbefehl. Aber bald, so warnen viele Experten, könnten die Roboter auch dies übernehmen. Viele Forscher und Aktivisten fordern ein Verbot vollautomatischer Kriegsroboter, und die UNO diskutiert kontrovers darüber.

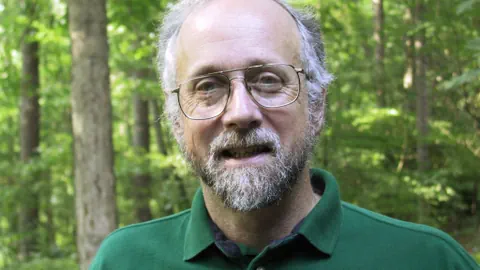

Nicht so schnell, sagt hingegen der amerikanische Roboterforscher Ron Arkin. Denn richtig gebaut, könnten Kriegsroboter sogar Menschenleben retten.

Deprimierend und verstörend

Eine Kriegsgurgel – das sei er keineswegs, betont Ron Arkin: Er arbeite auch an Pflegerobotern und hatte beim putzigen Roboterhund Aibo von Sony seine Finger im Spiel. Diese Forschung mache ihm Freude, sagt der Professor vom Georgia Institute of Technology.

Ganz anders sei es gewesen, als er sich mit dem Verhalten von Soldaten im Krieg befasst habe: «Das Verhalten von Soldaten im Einsatz zu studieren, war eine der deprimierendsten Erfahrungen, die ich im Lauf meiner Karriere machte. Es war sehr verstörend.»

Roboter handeln konsequenter

Erst letzte Woche habe die UN bekanntgegeben, dass während dem zweijährigen Krieg im Jemen 10‘000 Zivilsten getötet wurden, sagt Ron Arkin. Mit den richtigen Kriegsrobotern könnte das anders sein, lautet seine These:

«Einer der Wege, wie das Töten von Zivilisten verhindert werden kann, ist, in manchen heiklen Situationen automatische Waffensysteme einzusetzen. Diese halten sich konsequenter als menschliche Soldaten an die internationalen Menschenrechte und die Genfer Konvention, die Zivilisten schützt.» Voraussetzung sei, dass dem Roboter die Gesetzestreue einprogrammiert sei.

Menschen als Überwacher

«Tatsache ist: das Tempo auf dem Schlachtfeld nimmt täglich zu», gibt Ron Arkin zu bedenken. Unter diesen Umständen könne ein Mensch kaum mehr adäquat entscheiden. Ein Grund für die Beschleunigung sei, dass immer mehr halbautomatische Waffensysteme eingesetzt werden: Zum Beispiel das Phalanx-System, das US-Kriegsschiffe vor Raketen schützt.

Der Kapitän müsse das System zwar einschalten, aber wenn sein Schiff angegriffen werde, frage Phalanx vor dem Feuern nicht mehr um Erlaubnis. Solche halbautomatischen Systeme unterscheiden sich kaum mehr von vollautonomen Kriegsrobotern, findet Ron Arkin. Es sei gar nicht mehr möglich, eine klare Grenze zu ziehen.

Stets kühles Blut

Südkorea zum Beispiel lässt die Grenze zu Nordkorea von Robotern überwachen. Offiziell heisst es, ein Mensch müsse diesem den Feuerbefehl geben. Unbestätigte Quellen aber berichten von einem vollautomatischen Modus.

Für Ron Arkin nicht unbedingt ein Schreckensszenario: «Wenn Soldaten im Kampf Angst haben, vielleicht übermüdet sind, oder wütend – dann kann es passieren, dass sie falsch handeln.» Ein Roboter aber bewahre stets kühles Blut und halte sich an die Regeln, die man ihm einprogrammiert hat.

Künstliches Gewissen

Genau dies hat Arkin bereits getan, nicht bei einem realen Roboter, aber bei einem Computer. Das Herzstück ist eine Software, der «ethische Chef»: dieser überwacht, was der Roboter tun will und verweigert den tödlichen Schuss, wenn das Ziel ein Zivilist ist.

Ron Arkins Forschung wird unter Wissenschaftlern kontrovers diskutiert. Die Sicherheitsforscherin Heather Roff von der Arizona State University etwa glaubt nicht, dass ein solches System zuverlässig funktionieren wird – zumindest nicht in den nächsten Jahrzehnten.

Man könne einem Roboter zwar beibringen, nicht auf Objekte zu schiessen, die wie ein Schulbus aussehen. Das führe vermutlich dazu, dass weniger Schulbusse attackiert würden. Aber es sei für einen Roboter viel schwieriger, einen Kämpfer ohne Uniform von einem harmlosen Zivilisten unterscheiden zu können: «Das ist ein zu grosser Denkschritt.»

Debatte ist wichtig

Ethische Kriegsroboter à la Ron Arkin würden nur in wenigen, sehr speziellen Situationen funktionieren, glaubt Heather Roff. Das Militär werde kaum all die nötigen Millionen ausgeben für einen solchen Roboter, der erst noch den Schiessbefehl verweigern kann. Arkin habe zwar ehrenwerte Gründe für seine Forschung, aber sie komme einem Feigenblatt gleich.

Ron Arkin lässt diese Kritik gelten, er hat sie schon oft gehört. Und erwidert: «Die Debatte, die meine Forschung auslöst, ist ebenso wichtig, wenn nicht noch wichtiger, als diese Forschung selbst.»

Sendung: Radio SRF, Echo der Zeit, 19.01.17, 18 Uhr