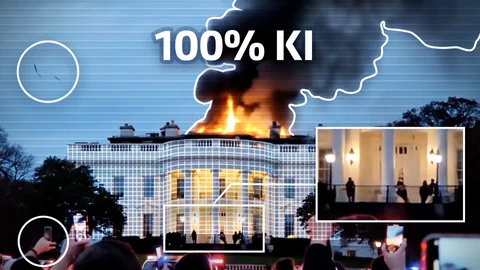

Feuer, Rauch, Sirenen – das Bild wirkt eindeutig: Das Weisse Haus steht in Flammen. Doch bei genauerem Hinsehen tauchen Ungereimtheiten auf: Hände verschmelzen, Einsatzfahrzeuge wirken verzerrt, Perspektiven stimmen nicht. Der Grund ist simpel: Das Video stammt nicht aus Washington, sondern von einer KI.

KI-Videos überschwemmen das Netz: Laut einer Studie ist bereits jedes vierte Top-Suchergebnis auf Tiktok KI-generiert – meist ohne Kennzeichnung. Während virtuelle Katzen harmlos bleiben, können gefälschte Nachrichtenbilder die Fakten verzerren und Menschen manipulieren.

Für diesen Artikel hat SRF News ein KI-Videotool Schweizer Newsereignisse erfinden lassen: ein Krokodil in der Limmat, 1. Mai-Chaoten, eine Demo in Bern und eine Überschwemmung in Basel. Der Aufwand dafür war überschaubar: ein Abo für rund 100 Dollar, ein paar Ideen – und einige Stunden Zeit.

Sehen Sie hier vier unveränderte Resultate der KI und wie sie entlarvt werden.

Das Krokodil in der Limmat

Klar gilt hier die Aufmerksamkeit einzig dem riesigen Krokodil. Kein Wunder werden dabei offensichtlich falsche Details schnell übersehen. Schauen Sie genau. Wo macht die KI Fehler?

1.Mai-Chaoten

Eine Überwachungskamera in der dunklen Gasse: Die Ästhetik vermittelt ein Gefühl der Authentizität. Dabei geht rasch unter, dass selbst einfachste physikalische Gesetze missachtet werden:

Demonstration in Bern

Berner und Bernerinnen und Politikinteressierte werden das «Bundeshaus» rasch entlarven. Das KI-Tool macht aber noch weitere klassische Fehler:

Überschwemmung in Basel

Wie immer beim «KI-Check» lohnt sich ein genauer Blick auf die Details. Zwei Tipps: «Stuhl» und «Kirche».

KI-Videos werden besser – aber kämpfen mit einer grossen Hürde

In Zukunft wird es noch schwieriger, KI generierte Videos zu erkennen, denn Modelle verbessern sich laufend: Sie können Text besser darstellen, die Tonspur klingt weniger blechern, Gesichter wirken überzeugender. Kurze Clips können so täuschend echt aussehen.

Trotzdem ist für SRF Digitalexperte Guido Berger ein Plateau erreicht: «Dass die KI bald ganze Spielfilme generiert: keine Chance.»

Die aktuellen Modelle hätten grosse Probleme, über eine längere Videodauer oder über mehrere Clips konsistent zu bleiben – so sieht eine Moderatorin in der nächsten Einstellung plötzlich ganz anders aus, ist anders angezogen oder hat ein anderes Mikrofon. Auch eine klare Vorstellung von Physik werden die heutigen Videomodelle kaum erlernen. «Es braucht eine neue Technologie, um das zu verbessern», sagt Berger. «Einfach immer mehr Daten zu verfüttern, reicht wohl nicht.»

Menge ist grösseres Problem als Realitätsnähe

Bis es möglich ist, längere von der Realität nicht zu unterscheidende Videos zu generieren, wird es daher noch dauern. «Doch das ist keine gute Nachricht», so Berger. «Es ist eine falsche Vorstellung, dass nur guter Content sich durchsetzt. Er muss bloss gut genug sein.»

In den sozialen Medien entscheiden die Userinnen und User meist innerhalb weniger Sekunden, ob sie etwas für glaubhaft halten oder nicht. Für einen ausführlichen Faktencheck ist da keine Zeit – generierte Videos müssen so nur auf den ersten Blick glaubwürdig wirken.

Es ist eine falsche Vorstellung, dass nur guter Content sich durchsetzt.

Hinzu kommt: «Das Internet ist inzwischen völlig zersplittert.» Guido Berger sagt, es komme zu einer Art Tribalisierung: In gleichgesinnten Gruppen im Internet sei das Zusammengehörigkeitsgefühl wichtiger als die Wahrheit. Solange ein Inhalt die eigene Meinung abbildet, wird ihm geglaubt – egal, wie realistisch er ist.

Problematischer als die Realitätsnähe von KI-generierten Inhalten sei zudem die schiere Menge. Das Internet wird regelrecht mit generierten Inhalten überflutet. Diese Flut unzuverlässiger Inhalte säht Misstrauen – es wird auch einfacher, «echte» Videos pauschal als generiert abzukanzeln.

SRF-Faktencheck-Team gefordert

Der Umgang mit Fake-News ist für das SRF-Netzwerk Faktencheck Alltag. 13 Mitarbeitende aus verschiedenen Abteilungen prüfen auf Anfrage Inhalte, gleichen Quellen ab und verifizieren Bilder und Videos. Leonard Flach ist Teil des Netzwerks und erklärt, wie das Team KI-generierte Clips entlarvt.

SRF News: Begegnen euch im Faktencheck-Team bei SRF auch KI-generierte Videos?

Leonard Flach: Ja, immer mehr. KI-generierte Videos beschäftigen uns inzwischen regelmässig. Sie tauchen oft im Kontext von viralen Clips auf – etwa bei den Angriffen zwischen Iran und Israel oder bei gefälschten Ansprachen vom Papst, in denen er den Weltuntergang ankündigt.

Wie geht ihr der Prüfung auf Echtheit vor?

Wir prüfen zuerst die «äussere Logik»: Wo und wann soll das Video entstanden sein? Gibt es unabhängige Quellen oder bereits Faktenchecks? Und ist der Inhalt plausibel? Beispiel: Ein von Trump verbreitetes Video zeigt angeblich Obamas unsanfte Festnahme im Oval Office – eine abwegige Situation und wohl nur eine Fantasie bestimmter Personen. Dann folgt die «innere Logik»: Wir achten auf visuelle Details wie falsche Schriften, unrealistische Gebäude, fehlerhafte Schatten oder unnatürliche Bewegungen.

KI-generierte Videos beschäftigen uns inzwischen regelmässig

Diesen Sommer tauchte ein Video auf, das einen angeblichen Angriff eines Orcas auf eine Trainerin während einer gut besuchten Veranstaltung zeigt – doch das Wasser, die Bewegungen und das regungslose Publikum deuten auf eine KI-Fälschung hin.

Wie kann ich in Zukunft sicherstellen, dass ein Video nicht «fake» ist – auch wenn es überzeugend echt aussieht?

Die Herausforderung wird grösser. Zwar gibt es neue Tools und Ideen wie digitale Wasserzeichen für «echte» Inhalte, doch Fälschungen bleiben technisch oft einen Schritt voraus. Wichtig ist deshalb ein kritischer Blick von Anfang an – und die Orientierung an vertrauenswürdigen Medien und Plattformen.